首页

产品与服务

大数据监测

乐思品牌监测云服务

乐思舆情监测云服务

大数据获取

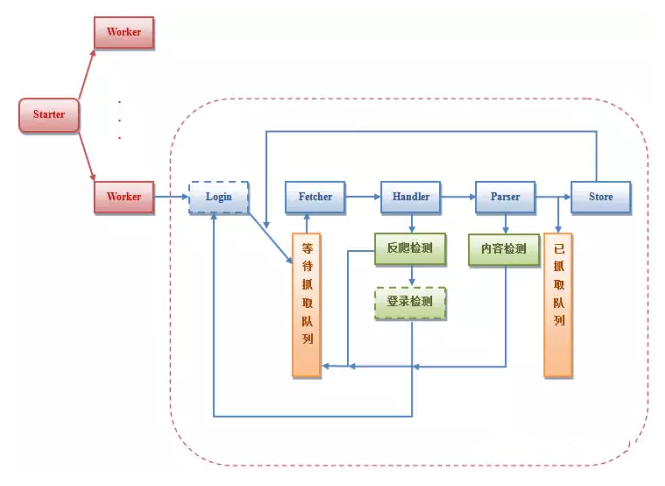

乐思网络信息采集系统

乐思编发系统

乐思大数据交付服务

大数据整合

乐思网络舆情监测系统

乐思网络情报中心系统

乐思流程机器人软件

乐思翻译中心系统

乐思网络情报监测系统

解决方案

政府

宣传部

公安厅

检察院

法院

环境保护厅

教育厅

人力资源社会保障局

安监局

国税局

物价局

食品药品监管局

旅游局

福彩中心

交通运输厅

上市公司

高校与研究机构

央企

银行

保险证券

互联网金融

房地产

汽车

媒体报业

旅游

手机

投资

医疗

客户案例

政府案例

企业案例

高校案例

科研单位案例

公司资讯

关于乐思

公司介绍

研发

资质

典型客户

代理合作

联系我们 400-603-8000

400-603-8000

400-603-8000

400-603-8000